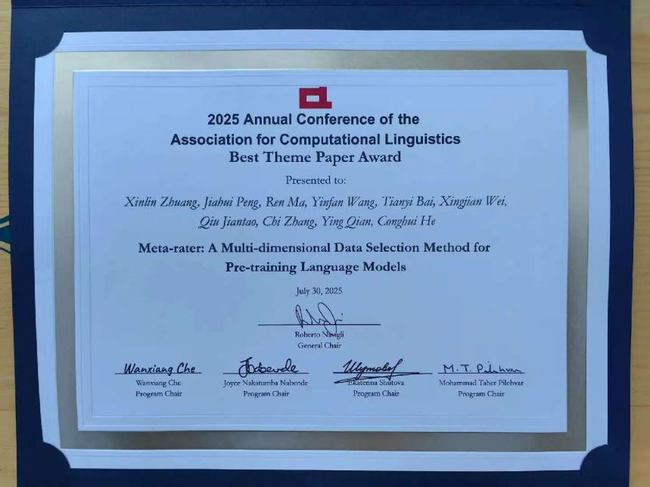

近日,由钱莹副教授指导的2023级学术型硕士研究生庄薪霖作为第一作者的论文荣获计算语言学和自然语言处理领域顶级国际会议 ACL 2025(The 63rd Annual Meeting of the Association for Computational Linguistics)“最佳主题论文奖”。这是华东师范大学计算机学院历史上首次在ACL大会上斩获该类重要奖项,实现了历史性突破。

ACL(Association for Computational Linguistics)由国际计算语言学协会组织,是自然语言处理(NLP)与计算语言学领域最具权威性和影响力的国际顶级学术会议,被中国计算机学会(CCF)列为A类推荐会议,其学术影响力长期位居全球NLP领域首位。第63届ACL大会于2025年7月27日至8月1日在奥地利维也纳隆重举行,吸引了来自世界各地的顶尖学者、研究人员和产业界专家共襄盛会。

本届大会投稿量再创新高,共收到论文投稿8360篇,竞争空前激烈。主会论文接收率为20.3%,Findings论文接收率为16.7%。大会最终评选出4篇最佳论文、2篇最佳社会影响力论文、3篇最佳资源论文、3篇最佳主题论文、26篇杰出论文等重要奖项。庄薪霖同学的研究成果从数千篇高质量投稿中脱颖而出,荣获“最佳主题论文奖”,充分体现了其工作的创新性、系统性与广泛影响力。

该获奖论文题为《Meta-rater: A Model-based Framework for Multidimensional Data Selection in LLM Pretraining》,由华东师范大学计算机学院与上海人工智能实验室联合完成。论文聚焦大语言模型(Large Language Models, LLMs)预训练过程中的核心挑战——数据质量评估与高效筛选。

当前,尽管数据被视为驱动大模型能力的关键要素,但现有的数据选择方法多局限于单一维度,如基于浅层文本特征、重复性过滤或简单分类器打分,缺乏对数据质量的系统性、多维度整合评估机制,导致预训练效率低下、模型性能受限。

针对这一关键问题,研究团队提出了两项核心创新:

四维数据质量评估框架:首次系统性地构建了一个涵盖信息密度、语义连贯性、知识丰富度与语言规范性四个维度的数据质量评估体系,并与现有指标融合,形成全面、可量化的评估标准。

Meta-rater:基于模型的多元数据选择方法:提出一种新颖的元学习框架。该方法通过训练数百个轻量级“代理模型”(surrogate models),模拟不同数据子集组合下的训练效果,并利用回归模型预测其在验证集上的损失。通过反向优化,Meta-rater能够自动学习25个不同质量维度指标的最优权重组合,从而实现对海量预训练数据的高效、精准筛选。

实验表明,采用Meta-rater筛选的数据集进行预训练,能够在显著减少训练成本的同时,提升模型在多种下游任务上的性能表现。该研究不仅验证了多维度数据质量整合的有效性,更为构建更高效、更强大的大语言模型提供了可扩展的新范式,对推动大模型预训练技术的发展具有重要意义。

论文英文标题:Meta-rater: A Multi-dimensional Data Selection Method for Pre-training Language Models

论文类别:Best Theme Paper

中山北路3663号理科大楼 200062

沪ICP备05003394

Copyright 2019计算机科学与技术学院